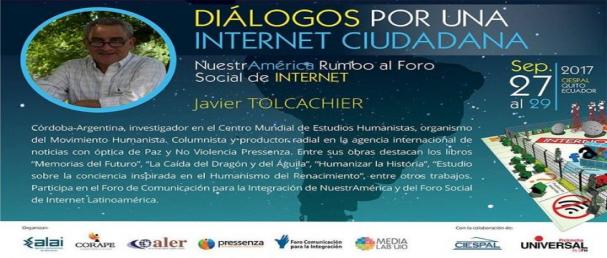

En el marco de los “Diálogos por una Internet Ciudadana”, jornadas que discuten la actual orientación monopólica de la Internet, Javier Tolcachier, investigador del Centro de Estudios Humanistas, desarrolló el tema del ciberarmamento. Las jornadas, organizadas por colectivos de comunicación latinoamericanos (ALAI, ALER, Pressenza, Corape, junto a Media Lab y el Foro de Comunicación para la Integración de NuestrAmérica), se desarrollan entre el martes 27 y el jueves 29 en la sede del Centro Internacional de Estudios Superiores de Comunicación para América Latina (CIESPAL) en Quito, Ecuador.

Publicamos aquí el contenido íntegro de su ponencia.

En 1942, el escritor de ciencia ficción Isaac Asimov enunció en su cuento Run Around (“Círculo Vicioso”) las que serían conocidas como “las 3 leyes de la robótica”. Su primer enunciado – preeminente sobre los dos siguientes – señalaba: “Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño”. El visionario humanista predecía ya en aquella breve historia cómo la robótica podría ser utilizada a futuro para cumplir tareas en ámbitos peligrosos para los humanos y avizoraba con claridad los problemas que se generarían en la relación entre autómatas y circunstancias desconocidas, no previstas o imprevisibles.

También en Japón, el padre del moderno comic japonés, Osamu Tezuka, formuló para su serie AstroBoy “Diez principios de la ley robótica”, cuyas dos sentencias iniciales indicaban que los robots debían servir a los humanos y que un robot nunca debía matar o herir a un ser humano.

La serie, cuyo personaje central es un niño androide, se constituiría en la animación predecesora del moderno estilo animé. Comenzó a ser dibujada en los años 50’ y es un reflejo de las traumáticas condiciones de las que debía emerger la sociedad japonesa luego de las detonaciones nucleares y la destrucción generalizada de la segunda guerra mundial.

Aunque ya el británico Alan Turing había propuesto la posibilidad de máquinas inteligentes, será en 1956 cuando el matemático y programador John McCarty acuñaría el concepto de “inteligencia artificial”, dando inicio junto a otro de los pioneros de la computación, Marvin Minsky, al primer laboratorio de IA en el Massachussets Institute of Technology (MIT). Su propósito era crear y programar máquinas que pudieran aprender como el ser humano. “Se intentará descubrir” – dice Mc Carthy – “cómo conseguir que utilicen el lenguaje, elaboren abstracciones y conceptos, resuelvan problemas que hasta ahora están reservados exclusivamente para los humanos y se mejoren a sí mismas”. En ese mismo año, la compañía International Business Machines (IBM) lanzaba su primera computadora al mercado, la “701”, diseñada por otro de los participantes en el taller de Dartmouth, Nathaniel Rochester. Posteriormente, mientras la industria incorporaba crecientemente la automatización y la computación se ampliaba y perfeccionaba, la inteligencia artificial, entre impulsores y críticos, victorias y derrotas – iba sumando procedimientos a su ajuar.

Los juegos fueron un campo de experimentación prolífico para la nueva disciplina, entre ellos el backgammon, el ajedrez y el go, juegos donde la estrategia y la combinatoria plantean un número imponente de posibles variantes, justamente una parte importante de los escenarios problematizados por la IA. Ya en 1979, un programa derrotaría al campeón mundial de backgammon Luigi Vila, mientras que en 1997, el ajedrecista ruso Gary Kasparov sería batido por el supercomputador Deep Blue. En 2016, AlphaGo, el programa desarrollado por la compañía DeepMind – fundada en 2010 y ahora propiedad de Google – venció al maestro coreano de la especialidad Lee Sedol, ganador de 18 títulos mundiales.

Los videojuegos fueron también un ámbito de experimentación para las empresas de IA. Un espacio peligrosamente cercano a la batalla y la guerra. En el reciente torneo internacional del videojuego Dota 2, un robot de OpenAI le ganó al jugador profesional Danylo “Dendi” Ishutin.

Open AI fue fundada por Elon Musk (Tesla, Space X, DeepMind) en colaboración con Sam Altman (Y Combinator) y es, según propias definiciones, “una compañía de investigación de inteligencia artificial sin fines de lucro” que trabaja en libre colaboración con otras instituciones con patentes e investigaciones abiertas. Para Musk, consciente de las potencialidades de la IA, la mejor defensa ante los riesgos potenciales de la IA es “empoderar el mayor número posible de personas con IA. Si todos tienen poder sobre la IA, entonces no habrá una persona o un grupo pequeño de individuos que tengan superpoderes de IA”. Curiosamente, este también es el mensaje más reciente de Google y Microsoft, para quienes “democratizar el acceso” significa multiplicar masivamente una tecnología para aumentar sus rendimientos económicos y su poder en la materia.

La IA ha logrado ya múltiples avances en el campo del aprendizaje, el reconocimiento facial, el lenguaje, la identificación óptica, el diagnóstico preventivo de enfermedades, la comunicación, la domótica, el transporte no tripulado, la robótica industrial y doméstica y en un gran número de aplicaciones y sistemas informáticos en los más diversos campos.

Pero al mismo tiempo, en el ambiente hipermilitarista de los EEUU, comenzaron ya tempranamente a desarrollarse distintos proyectos de utilización militar de armas semiautónomas. En los ‘80, la marina estadounidense instalaba en sus barcos el MK 15 Phalanx Close-In Weapons System, construido por Raytheon, que detecta misiles o aviones amenazantes, respondiendo con ametralladoras. Según la firma, 890 sistemas de esta clase fueron construidos y usados por las fuerzas navales de 25 países. Modelos similares como el Counter Rocket, Artillery, and Mortar System (C-RAM) (fabricado por Northrop Grumman) se instalaron en tierra en 2005 en Irak. Sistemas de este tipo para repeler ataques fueron desarrollados también por Israel (Iron Dome) y Alemania (NBS Mantis) que los utilizó en Afganistán.

Ya en 1991, en el transcurso de la Guerra del Golfo, el ejército norteamericano utilizaría la Herramienta de Análisis Dinámico y Replaneamiento (DART), desarrollada en base a inteligencia artificial para resolver problemas de aprovisionamiento, personal y logística.

Para los planificadores de la guerra, el objetivo es desde hace tiempo obvio: perfeccionar las maquinarias mortales, transfiriendo la máxima cantidad de responsabilidad a sofisticadas tecnologías. Para ello, la inteligencia artificial es una rama de investigación y aplicación esencial.

El estado de la cuestión del armamento letal autónomo

Ante todo, es necesario precisar que existen armas con distinto tipo de autonomía, todas encuadrables en la categoría de “robots asesinos”. Según el reporte “Perdiendo Humanidad” de Human Rights Watch, todavía no existe armamento con autonomía total, pero sí tecnología apuntando en esa dirección y prototipos en uso.

En cuanto a las modalidades intermedias de autonomía, además de las ya señaladas de respuesta automática, existen armas de vigilancia con capacidad de fuego monitoreada, como el SGR-1s, instalado por Corea del Sur a lo largo de la zona desmilitarizada con Corea del Norte o el Sentry Tech y el Gardium (de la empresa G-NIUS), colocado por las Fuerzas armadas israelíes en la frontera con Gaza. Por último, está el armamento de autonomía relativa operado a distancia como los mortíferos drones de EEUU Predator y Reaper, que han causado un sinnúmero de víctimas en Pakistán, Somalía, Yemen, Afganistán e Irak.

Los EEUU, si bien notorios impulsores de la utilización armamentística de la IA, no son los únicos en desarrollar esta barbarie tecnificada. Gran Bretaña realizó en 2013 el vuelo de prueba de un prototipo de su avión de combate Taranis (BAE Systems), no tripulado, autónomo, con capacidad de portar bombas o misiles y de recargar combustible en el aire, sin intervención remota. Prototipos similares fueron desarrollados por Francia (nEUROn, Dassault Aviation), Alemania/España (Barracuda, EADS), Rusia (Skat, MIG), Israel (Harpy) y USA (X-45, Boeing y X-47B, Northrop Grumman). Incluso India ha comenzado con un proyecto similar (Aura, DRDO).

Existe ya un arsenal numeroso de vehículos, tanques, bombas, sistemas de monitoreo, robots de carga y combate, navíos y submarinos, cuya utilización de diferentes aspectos de la IA manifiestan claramente la dirección hacia una mayor autonomía.

En un lineamiento de la división Investigación e Ingeniería del Departamento de Defensa de los EEUU de Mayo 2014, se indica que “las tecnologías asociadas con la autonomía se van multiplicando: desde sensores capaces de entender el medio circundante a programas con algoritmos que pueden tomar decisiones o buscar asistencia humana. A través de la autonomía, deberíamos ser capaces de reducir el personal requerido para efectuar misiones de manera segura.”

Del mismo modo, en la hoja de ruta de la COI Autonomía (una de las diecisiete “comunidades de interés” temático en las que el Departamento de Defensa ha dividido sus proyectos de desarrollo tecnológico-militar) se exhibe una proyección de tres fases que, pasando por una etapa de escuadrillas de combate aéreo totalmente autónomo, culmina en un acople escalable de sistemas autónomos. La aspiración a mediano plazo es lograr sistemas integrados (Tactical Battle Manager (TBM)) para apoyar operaciones combinadas de distintos tipos de vehículos armados autónomos en zonas adversarias.

La Bolsa o la Vida

Otra de las motivaciones del aprovechamiento de la IA para propósitos militares – acaso la principal – es el lucro. Las tecnologías emergentes son fuente de enormes negocios en general y las corporaciones del complejo militar industrial no quieren quedar afuera.

La consultora Tractica anticipa que “el mercado de robótica experimentará un fuerte crecimiento entre 2016 y 2022 a través de ganancias por la venta de unidades (excluyendo servicios de instalación e integración) desde actuales 31 mil (2016) a 237.3 mil millones u$ en 2022. La mayor parte de este crecimiento será motorizado por robots no industriales, incluyendo segmentos como consumidores finales, empresas, salud, fuerzas armadas, unidades de vuelo no tripuladas y vehículos autónomos.”

Por todo ello, hay enormes inversiones, principalmente de las grandes empresas de informática en desarrollos de IA, a través de la compra de empresas dedicadas. Cincuenta compañías del rubro fueron vendidas en 2016, once por importes mayores a 500 millones. Entre las principales compradoras destacan Alphabet/Google, Apple, Amazon, IBM and Microsoft. China por su parte planifica el crecimiento de su industria de IA de 22 mil millones en 2020 a 150 mil en 2030.

En particular, el mercado de robótica militar saltará de actuales 16.8 (2017) a 30.83 miles de millones de dólares para 2022, en tan sólo cinco años. La expectativa es que el gasto militar en robótica se triplique entre 2010 y 2025.

Las ganancias de las principales compañías aeroespaciales, todas ellas involucradas en proyectos de uso militar con un elevado componente de IA hablan por sí solas. Según datos de 2015, Boeing ganó en concepto de ventas más de 96 mil millones, Airbus, ahora EADS, 71.516; Lockheed Martin, 46132; General Dynamics, 31469; seguidas por United Technology, BAE Aviation, GE Aviation y Raytheon con ganancias entre 23 mil y 28 mil millones de dólares. Según un análisis de la consultora Deloite, el subsector Defensa se expande mientras el crecimiento de las ganancias de la aviación civil se enlentece.

Otros actores relevantes en el Mercado de armas robóticas son iRobot Corp., Allen-Vanguard Corporation, Honeywell Aerospace, GeckoSystems Intl. Corp., Honda Motor Co. Ltd., Bluefin Robotic Corp., AB Electrolux, Deep Ocean Engineering Inc., ECA Hytec SA, McArtney Group, Fujitsu Ltd., Toyota Motor Corp., AeroVironment, Kongsberg Gruppen, Saab AB, Elbit System Ltd., Thales Group (France), entre otras.

En cuanto a los potenciales compradores, informes estiman que un 10% estará destinado a América del Norte, un 20% a Europa, un 40% a la zona Asia-Pacífico y 50% al resto del mundo, porción que primariamente irá a países de Medio-Oriente.

Los prospectos indican que la mayor parte de los países está dispuesta a adquirir tecnología aérea no tripulada (drones), vehículos terrestres autónomos y robots de patrullaje y espionaje, entre otras armas. De esta manera, es inminente una carrera armamentista en este sentido, por la desestabilización que suscita (y es alimentada) por cada innovación tecnológica en lo militar. Con ello queda descartado que el uso de IA para fines militares contribuya, al menos en el corto plazo, a reducir los presupuestos de defensa.

Robots que aniquilan vidas humanas

Los defensores-lobbystas de los robots militares, dicen que su uso permitirá disminuir el número de víctimas. Señalan que al haber menos efectivos involucrados directamente en batalla habría menos muertos. Invocando escenarios de guerra entre máquinas, indican que incluso las víctimas civiles serían menores por la mayor precisión de armamento equipado con alta tecnología de rastreo y detección.

Esto es por supuesto una falacia. Los miles de muertos por bombardeo de drones estadounidenses en Afganistán, Iraq, Yemen, Somalia y Pakistán, son prueba dolorosa y suficiente de ello. Según el periódico pakistaní Dawn News (citado por Red Voltaire), “Por cada presunto miembro de al-Qaida o de los talibanes muerto por misiles disparados desde drones de EE.UU. “también tuvieron que morir 140 inocentes paquistaníes. Más de un 90 por ciento de los muertos en los mortíferos ataques con misiles fueron civiles, afirman las autoridades”. En la misma línea, el informe de la organización humanitaria de DDHH Reprieve de 2014, indica que por cada blanco intencional, los bombarderos teledirigidos de los EEUU mataron veintiocho civiles.

En cuanto a las víctimas militares, en la actualidad los robots mortíferos sirven solamente a un bando, que efectivamente puede reducir sus muertos, no así su enemigo. Esta suerte de “combate a distancia” permite a los atacantes la posibilidad de guerras múltiples en simultáneo y anestesia a sus propias poblaciones sobre sus devastadores efectos.

El sufrimiento, la indignación y la impotencia generada en terreno por ataques con estas armas no hace sino atizar los deseos de venganza en las poblaciones agredidas, sembrando una nueva ola de terror y violencia inacabable.

Las armas con tecnología de IA permiten efectivamente destruir con mayor facilidad la infraestructura del país atacado, lo cual dificulta el desarrollo local, creando condiciones de exclusión social que alimentarán la espiral de guerra con nuevas cohortes de desocupados.

Por otra parte, la robótica no sólo será utilizada para la guerra, sino también para acrecentar las posibilidades de vigilancia y patrullaje, incluso como apoyo o sustitución de cuerpos policiales o fuerzas de seguridad privadas. Apoyada en la ventaja de su presencia permanente (24/7) los efectos de control masivo a toda la población son evidentes. Por otra parte, las facultades de autonomía ampliarán la posibilidad de violación a los derechos humanos sin ninguna responsabilidad a cargo. Esto es por supuesto intolerable.

Un futuro diferente

Ante estos escenarios y horizontes, ya ha comenzado a levantarse el clamor de científicos, académicos, inversores y precursores de la IA para proscribir la utilización de esta tecnología con fines militares.

Previo a la reciente Conferencia Internacional sobre Inteligencia Artificial (IJCAI 2017) en Melbourne, 116 fundadores de compañías de robótica e IA exhortaron en una carta abierta a las Naciones Unidas a prohibir los LAWS (Sistemas autónomos de armas letales, por sus siglas en inglés).

Los firmantes de la carta señalan que “las armas letales autónomas amenazan con constituir la tercera revolución en las guerras. Una vez desarrolladas, permitirán que los conflictos armados tengan una escala nunca antes vista y una velocidad mucho mayor de lo que el ser humano pueda comprender. Estas pueden ser armas de terror, armas que déspotas y terroristas usarán contra poblaciones inocentes, armas que serán hackeadas para actuar de manera no deseada. No tenemos mucho tiempo para actuar. Una vez que esta caja de Pandora sea abierta, será difícil cerrarla.”

Ya en Diciembre 2016 – señala el instituto Future of Life – 123 países miembros de la Convención Internacional sobre Armas Convencionales, acordaron unánimemente comenzar discusiones formales sobre armamento autónomo y 19 naciones ya se pronunciaron por su prohibición. En los trabajos previos a la conferencia, además de países contratantes de la Convención y observadores, participaron diversas organizaciones de la sociedad civil tales como Human Rights Watch, Campaign to Stop Killer Robots, Campaña Internacional para la Prohibición de las Minas Terrestres (ICBL), Mines Advisory Group (MAG), Walther-Schücking-Institut für Internationales Recht, y Liga Internacional de Mujeres por la Paz y la Libertad (WILPF).

En el transcurso de la Quinta Conferencia de Examen de la Convención se decidió instituir un comité de expertos gubernamentales (GGE, en inglés) que debía sesionar en Abril o Agosto y en segundo término, en Noviembre de 2017. La primera sesión fue cancelada por dificultades presupuestarias, por lo que ahora las miradas y acciones de la Campaña activista contra los robots asesinos (Stop KillerRobots), están puestas en la reunión a realizarse en Noviembre.

En su informe de Abril 2013, el Alto Comisionado de Naciones Unidas sobre ejecuciones extrajudiciales, arbitrarias o sumarias Christof Heyns, señalaba que aún cuando los responsables gubernamentales aseveran que la utilización de armamento autónomo no está prevista de momento, “experiencias sucesivas demuestran que cuando una tecnología que provee evidentes ventajas sobre un adversario está disponible, las intenciones iniciales son frecuentemente dejadas de lado”. Algo más adelante, dice el diplomático: “Si el marco legal internacional debe ser reforzado contra las presiones del futuro, esto debe hacerse mientras aún sea posible”.

Y esto es precisamente lo que reclaman las alianzas activistas exigiendo

– La prohibición de desarrollo y uso de armas completamente autónomas a través de un tratado internacional vinculante.

– La adopción de leyes y políticas nacionales que prohíban el desarrollo, producción y uso de armas completamente autónomas.

– La revisión de tecnologías y componentes que pudieran conducir al desarrollo de armamento autónomo.

En lo que a nosotros respecta, agregamos que además de la prohibición legal vinculante, lo que tenemos que lograr es un cambio en la dirección mental.

La inteligencia artificial continuará su avance, pero solamente podrá ayudar a resolver problemas humanos, si avanza la inteligencia humana. Un arma nunca es inteligente, una guerra nunca es inteligente, esté apoyada por tecnología autónoma o no.

No es el caso, ni es posible detener el conocimiento o la ciencia, ya que son inherentes a la historia humana. Impedir el accionar destructivo de gobiernos y corporaciones de negocios es ciertamente necesario pero tan sólo parte del acertijo. Algo debe también cambiar en nuestra interioridad, en la perspectiva de vida de los conjuntos humanos.

Los robots nunca alcanzarán la inteligencia humana, por una simple razón: también somos seres en desarrollo. Avanzamos aprendiendo de nuestros aciertos y también – aunque a veces no lo parezca – de nuestros errores. Y sobre todo, somos seres que evolucionamos – con lentitud pero con persistencia de milenios – hacia un nuevo tipo de humanidad, bondadosa, empática y compasiva, virtudes difícilmente apresables por algoritmos.

Como prueba fehaciente de esa evolución, y como un paso más hacia el fin de todas las guerras y todo armamento, prohibamos el armamento robótico.

@jtolcachier